Pekiştirmeli öğrenme

Pekiştirmeli öğrenme, davranışçılıktan esinlenen, öznelerin bir ortamda en yüksek ödül miktarına ulaşabilmesi için hangi eylemleri yapması gerektiğiyle ilgilenen bir makine öğrenmesi yaklaşımıdır. Bu problem, genelliğinden ötürü oyun kuramı, kontrol kuramı, yöneylem araştırması, bilgi kuramı, benzetim tabanlı eniyileme ve istatistik gibi birçok diğer dalda da çalışılmaktadır.

| Makine öğrenmesi ve veri madenciliği |

|---|

|

|

Problemler

|

|

|

|

|

|

Yapılandırılmış tahmin

|

|

Anomali tespiti

|

|

|

|

Teori

|

|

Konferanslar ve dergiler

|

Makine öğrenmesinde, ortam genellikle bir Markov karar süreci (MKS) olarak modellenir, bu bağlamda birçok pekiştirmeli öğrenme algoritması dinamik programlama tekniklerini kullanır.[1] Pekiştirmeli öğrenme algoritmalarının klasik tekniklerden farkı, MKS hakkında ön bilgiye ihtiyaç duymamaları ve kesin yöntemlerin verimsiz kaldığı büyük MKS'ler için kullanılmalarıdır.

Pekiştirmeli öğrenme, doğru girdi/çıktı eşleşmelerinin verilmemesi ve optimal olmayan eylemlerin dışarıdan düzeltilmemesi yönleriyle gözetimli öğrenmeden ayrışır. Dahası, pekiştirmeli öğrenmede bilinmeyen uzayda keşif (İngilizce: exploration) ile mevcut bilgiden istifade (İngilizce: exploitation) arasında bir denge kurma söz konusudur.[2]

Giriş

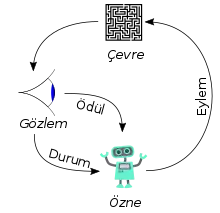

Temel pekiştirmeli öğrenme modeli şunlardan oluşur:

- öznenin ve ortamın durumlarını (İngilizce: state) içeren bir kümesi;

- öznenin yapabileceği eylemleri (İngilizce: action) içeren bir kümesi;

- her durumda hangi eyleme geçileceğini belirleyen prensipler (İngilizce: policy);

- bir durum geçişinin kazandıracağı skaler anlık ödülü hesaplamak için kurallar;

- öznenin gözlemlerini betimlemek için kurallar.

Kurallar sıklıkla stokastiktir. Gözlemler genellikle son yapılan durum geçişinin kazandırdığı ödülü içerir. Birçok çalışmada öznenin mevcut ortam durumunu gözlemleyebildiği kabul edilir, yani tam gözlenebilirlik. Ancak bunun karşıtı durumlar da söz konusudur ve kısmi gözlenebilirlik olarak adlandırılır. Bazı durumlarda öznenin yapabileceği eylemler kısıtlanmıştır (örn. harcanabilecek para miktarı).

Bir pekiştirmeli öğrenme öznesi ortamla ayrık zaman adımlarında etkileşir. Her zaman adımında, özne ödülüne sahip bir gözlemi alır. Bunun üzerine müsait eylemler kümesinden bir eylemi seçer ve bu yolla ortamla etkileşir. Ortam yeni bir durumuna evrilir. Yeni durumla ilişkili ödülü de belirlenir. Bu ödül geçişine aittir. Pekiştirmeli öğrenme öznesinin amacı mümkün olduğunca fazla ödül toplamaktır. Özne eylemlerini geçmiş durumların bir fonksiyonu olarak seçebilir, hatta eylem seçimini rassal olarak yapabilir.

Bir öznenin performansı mükemmel davranışa sahip özneninki ile karşılaştırıldığında, aralarında oluşan performans kaybı pişmanlık terimi ile ifade edilir. Mükemmel davranışa ulaşmak için, bir özne eylemlerinin uzun vadeli sonuçlarını dikkate almalıdır (gelecekteki çıkarlarını yükseltmek amacıyla). Özne bunun için kısa vadeli ödüllerden vazgeçebilmelidir.

Bu yüzden, pekiştirmeli öğrenme uzun ve kısa vadeli ödüller arasında tercih yapmayı gerektiren problemler için iyi bir yaklaşımdır. Robot kontrolü, telekomünikasyon, tavla, dama ve go (AlphaGo) gibi birçok konuda başarıyla uygulanmıştır.

Keşif

Pekiştirmeli öğrenme akıllı bir keşif mekanizmasına ihtiyaç duyar. Eylemlerin, herhangi bir olasılıksal dağılımına bağlı kalmadan, rastgele seçilmesi kötü bir performansa neden olabilir. Küçük (sonlu) Markov karar süreçleri (MKS) için keşif problemi iyi anlaşılmıştır. Ancak, büyük uzaylı Markov karar süreçleri için başarısı kanıtlanmış algoritmalar olmadığından ötürü daha basit keşif yöntemleri tercih edilmektedir.

Bu yöntemlerden biri aç gözlü hareket belirlemedir (-greedy). Bu yönteme göre ihtimalle rastgele bir eylem yapılır, ihtimalle ise uzun vadede en iyi sonucu getireceği hesaplanan eylem yapılır.[3] Burada, ayar parametresi olarak kullanılır; arttıkça keşif eğilimi artar, azaldıkça sömürü (İngilizce: exploitation) eğilimi artar. Bu ayar parametresi belirli bir zamanlamaya göre değişebileceği gibi (keşfi yavaşça ve sürekli azaltmak), sezgisel bir şekilde de uyarlanabilir.[4]

Derin pekiştirmeli öğrenme

Derin öğrenme ile pekiştirmeli öğrenmeyi birleştiren yaklaşımlara denir. Öğrenme sistemi diğer pekiştirmeli öğrenme yöntemleriyle aynıdır (durum, eylem, ödül vb.), ancak sistemin bazı kısımları derin yapay zeka ağları ile modellenir.[5] Örneğin verilen bir durum-eylem ikilisine karşılık gelen ödül miktarını öğrenmek için derin öğrenme kullanılabilir. Google DeepMind tarafından geliştirilen, ATARI oyunlarını oynayan yapay zeka uygulaması[6] derin pekiştirmeli öğrenmeye olan ilgiyi artırmıştır.

Ters pekiştirmeli öğrenme

Ters pekiştirmeli öğrenmede öntanımlı bir ödül fonksiyonu yoktur. Onun yerine, bir uzmanın davranışları gözlemlenerek bir ödül fonksiyonu öğrenilir. Ana fikir mükemmel ya da mükemmele yakın olan davranışı gözlemlemek ve taklit etmektir.[7]

Kaynakça

- van Otterlo, M.; Wiering, M. (2012). "Reinforcement learning and markov decision processes". Reinforcement Learning. Springer Berlin Heidelberg. ss. 3-42. 26 Nisan 2017 tarihinde kaynağından arşivlendi. Erişim tarihi: 31 Ocak 2017.

- Kaelbling, Leslie P.; Littman, Michael L.; Moore, Andrew W. (1996). "Reinforcement Learning: A Survey". Journal of Artificial Intelligence Research. Cilt 4. ss. 237-285. 20 Kasım 2001 tarihinde kaynağından arşivlendi. Erişim tarihi: 1 Şubat 2017.

- Alpaydın, Ethem (2011). Yapay öğrenme (1.basım bas.). İstanbul: Boğaziçi Üniversitesi Yayınevi. ISBN 9786054238491.

- Tokic, Michel; Palm, Günther (2011). Value-Difference Based Exploration: Adaptive Control Between Epsilon-Greedy and Softmax"KI 2011: Advances in Artificial Intelligence" (PDF). Lecture Notes in Computer Science. Cilt 7006. Springer. ss. 335-346. ISBN 978-3-642-24455-1. 23 Kasım 2018 tarihinde kaynağından (PDF) arşivlendi. Erişim tarihi: 20 Aralık 2017.

- Francois-Lavet, Vincent (2018). "An Introduction to Deep Reinforcement Learning". Foundations and Trends in Machine Learning. 11 (3–4). ss. 219-354. doi:10.1561/2200000071. 11 Temmuz 2019 tarihinde kaynağından arşivlendi. Erişim tarihi: 11 Temmuz 2019.

- Mnih, Volodymyr (2015). "Human-level control through deep reinforcement learning". Nature. 518 (7540). ss. 529-533. Bibcode:2015Natur.518..529M. doi:10.1038/nature14236.

- Ng, A. Y.; Russell, S. J. (2000). Algorithms for inverse reinforcement learning. Icml. ss. 663-670.